Herramientas de análisis de datos: guía completa para profesionales en 2026

¿Cuáles son las mejores herramientas de análisis de datos disponibles en 2026? ¿En qué escenarios conviene usarlas? Y lo más importante: ¿cómo elegir la opción más adecuada a las necesidades de tu empresa o proyecto? En este artículo te llevamos más allá de lo básico.

Si ya trabajas con datos, aquí encontrarás una comparación práctica entre herramientas populares como Excel, SQL, Power BI, Python, R y Apache Spark, con ejemplos de aplicación en negocios reales. El objetivo es que puedas identificar cuándo usar cada una, qué limitaciones considerar y cómo combinarlas para obtener informes más claros, procesos más eficientes y mejores decisiones basadas en datos.

¿Qué son las herramientas de análisis de datos?

Son aquellas plataformas, programas o lenguajes de programación diseñados específicamente para recopilar, organizar, procesar e interpretar grandes cantidad de datos. El objetivo final es que puedan obtener conclusiones que ayuden en la toma de decisiones de manera efectiva.

Estas herramientas no solo permiten manejar grandes volúmenes de datos, sino realizar cálculos complejos, crear gráficos interactivos, identificar patrones y generar modelos predictivos. En otras palabras, transforman grandes cantidades de información aparentemente desordenada en soluciones claras y listas para ser realizadas.

¿Por qué son importantes las herramientas de análisis de datos para la toma de decisiones?

No existe ningún otro momento en la historia en que los seres humanos hayamos generado tanta cantidad de datos que se puedan medir. Cada clic es un dato. Cada segundo mirando la pantalla es otro dato. Cada like en redes sociales, otro dato. De hecho, Spacelift estima que en 2025 la cantidad de datos generados a diario en el mundo es de 328,77 millones de terabytes, lo que representa aproximadamente 0,33 zettabytes por día.

El volumen de datos es tan grande que resulta imposible procesarlo rápidamente de forma manual (incluso para un verdadero genio en matemáticas).

Por esta razón, las herramientas de análisis de datos permiten a los Data Analyst:

🔷 Procesar grandes volúmenes de información en pocos segundos.

🔷 Identificar oportunidades y riesgos con rapidez.

🔷 Personalizar productos y servicios a partir de patrones de consumo.

🔷 Mejorar la eficiencia de procesos internos.

🔷 Optimizar recursos para la toma de decisiones estratégicas.

Sin el apoyo de las herramientas de análisis de datos, las empresas y organizaciones se quedarían atrás frente a competidores más ágiles.

En un mercado cada vez más competitivo, tener una nube con bases de datos y un personal muy capacitado no tiene valor por sí solo; también necesitas herramientas que transformen esos números en resultados tangibles en un abrir y cerrar de ojos.

El valor agregado del análisis de datos

Las empresas de todo el mundo entienden que un manejo correcto de los datos marca la diferencia entre un negocio exitoso y uno que pierde competitividad. Por este motivo, el análisis de datos ya no es un proceso opcional, sino la base para optimizar recursos, responder a las necesidades de los usuarios y diseñar soluciones estratégicas en tiempo real.

Según el informe Future of Jobs Report 2025 del Foro Económico Mundial, la habilidad del análisis de datos se encuentra entre las más demandadas y con los mejores salarios del mercado laboral global.

Impacto del análisis de datos en las empresas

Las bases de datos tienen un valor inmenso para las empresas porque les permite acceder a información para:

🔶 Predecir tendencias del mercado y adaptarse rápidamente.

🔶 Segmentar clientes y ofrecer productos personalizados.

🔶 Optimizar operaciones internas, desde logística hasta gestión financiera.

🔶 Medir resultados en tiempo real para mejorar la rentabilidad.

Uno de los ejemplos más claros está en la industria retail, donde las cadenas de supermercados se concentran cada vez más en hacer un análisis periódico de grandes volúmenes de datos, con el fin de ajustar inventarios a medida que los usuarios demuestran cierto comportamiento. Así, se evita tanto el exceso de stock, como la falta de productos.

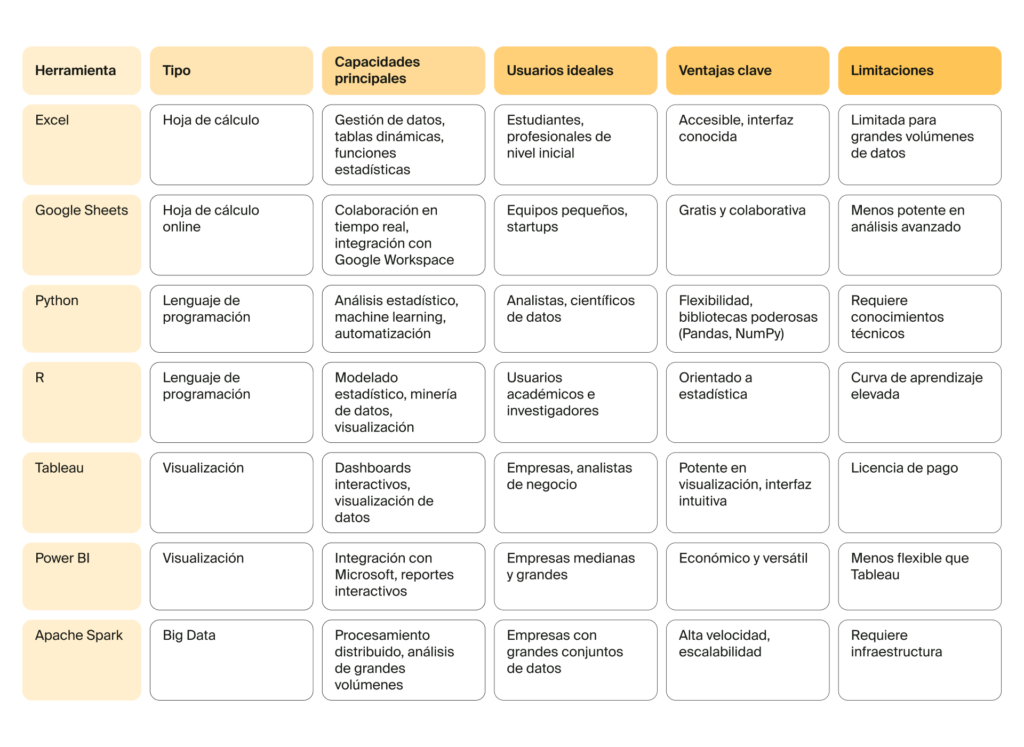

Las mejores herramientas de análisis de datos en 2025

En un mercado donde los datos son el activo más valioso, es imprescindible que las empresas que quieran diferenciarse de su competencia cuenten con las mejores herramientas de análisis y visualización de grandes volúmenes de datos.

En 2025 el campo del análisis de datos ofrece una gran variedad de opciones que responden a distintas necesidades; algunas orientadas exclusivamente a la visualización de datos, otras diseñadas para el tratamiento de grandes volúmenes de información. También hay plataformas enfocadas en la automatización de procesos y modelos predictivos.

La elección adecuada no depende solo del software, sino del perfil del analista, los objetivos del proyecto y las prioridades de la empresa o institución.

Veamos ahora las herramientas análisis de datos de mayor importancia, sus características y cuándo es más conveniente usarlas.

Lenguajes de programación para el análisis de datos: Python y R

Comencemos por Python, que se consolidó como el lenguaje de programación más utilizado en el análisis de datos por su versatilidad y por el enorme ecosistema de bibliotecas disponibles: Pandas, NumPy, Matplotlib y Scikit-learn, entre otras.

Estas funciones permiten a los usuarios limpiar, transformar y analizar grandes volúmenes de datos, así como crear visualizaciones y aplicar modelos de Machine Learning.

Entre las ventajas de Python, destacan:

🔷 Automatización de procesos repetitivos.

🔷 Manejo eficiente de bases de datos y almacenamiento en la nube.

🔷 Integración con plataformas de negocio y servicios web.

🔷 Capacidades para trabajar con cantidades masivas de datos, junto con tecnologías de código abierto como Apache Spark o Apache Hadoop.

Python es ideal para empresas que buscan generar análisis a partir de un volumen considerable de datos, y transformarlos en informes estratégicos para optimizar la toma de decisiones. Su interfaz de usuario sencilla y su comunidad activa lo convierten en una de las herramientas de análisis más poderosas y accesibles del mercado.

R, en cambio, se distingue por estar más orientado al análisis estadístico profundo y a la minería de datos. Es especialmente popular en entornos académicos, laboratorios de investigación, y en áreas que requieren altos niveles de seguridad, ya que implica una comprobación rigurosa de hipótesis, modelos y variables.

Entre las ventajas de R para el análisis de datos podemos destacar:

🔶 Amplia colección de paquetes para métodos estadísticos avanzados.

🔶 Capacidades sólidas para generar gráficos y visualizaciones de alta calidad.

🔶 Funciones diseñadas para detectar patrones en conjuntos de datos complejos.

🔶 El uso extendido en disciplinas que requieren trabajar con modelos matemáticos de alta precisión.

Entonces Python o R, ¿cuál conviene elegir?

Python es ideal para proyectos que combinan análisis, visualización de datos, desarrollo de aplicaciones y uso de Machine Learning, mientras que R es la opción preferida cuando la prioridad es el análisis estadístico, la verificación científica y la representación detallada de datos.

Si quieres ir paso a paso con el análisis de datos, puedes comenzar por aprender lenguajes de programación hoy mismo.

Hojas de cálculo avanzadas

No son lo más nuevo bajo el sol, pero aún son una de las mejores herramientas de análisis de datos para empresas y usuarios.

🔷 Excel es la herramienta más utilizada para exportar, crear análisis y visualizar datos, así como crear informes y manejar grandes volúmenes de datos que apoyen la toma de decisiones en el negocio.

🔷 Google Sheets se destaca por su colaboración en tiempo real, lo que permite a los equipos trabajar sobre los mismos conjuntos de datos desde cualquier lugar.

Ambas plataformas son clave para optimizar procesos, generar visualizaciones de datos y conectar con herramientas avanzadas como Python, Power BI o Tableau.

Herramientas de Big Data: Apache Spark y Apache Hadoop

Cuando se trata de grandes volúmenes de datos, las herramientas de análisis tradicionales no siempre son suficientes. En estos casos, las soluciones de Big Data son la mejor alternativa, y en 2025 existen dos que lideran la industria.

Por un lado, Apache Spark destaca por su capacidad de procesamiento en memoria; es decir, la ejecución de tareas de procesamiento de datos o cálculos directamente dentro de la memoria RAM de una computadora, en lugar de enviarlos a dispositivos de almacenamiento más lentos como discos duros.

Esto le permite ser aún más veloz que las demás, y la convierte en ideal para:

🔶 Realizar análisis de datos en tiempo real.

🔶 Machine Learning.

🔶 Generación de informes y visualizaciones casi inmediatos.

Por otro lado, Apache Hadoop --diseñado para el almacenamiento y procesamiento distribuido de grandes volúmenes de información--, es una plataforma de código abierto ampliamente utilizada por organizaciones que necesitan analizar y visualizar datos de manera escalable.

Sus capacidades permiten combinar bases de datos, ejecutar procesos complejos, y mantener la seguridad y confianza en los datos.

Herramientas de visualización de datos: Tableau y Power BI

Una vez realizado el análisis, es fundamental cargar la información a una plataforma o software que le permita crear «visualizaciones» o «gráficos» a partir de los datos extraídos.

Hay que tener en cuenta que tanto el analista como el científico de datos, deben comunicar sus predicciones y observaciones a equipos de otras áreas de manera clara y eficiente.

Entre las herramientas de visualización de datos se destacan dos: Tableau y Power BI.

Tableau permite crear dashboards interactivos con los datos. Es ampliamente utilizada en áreas de marketing, finanzas y gestión de grandes volúmenes de datos, ya que ofrece informes dinámicos que ayudan a los usuarios a detectar patrones, tendencias y oportunidades de negocio.

Power BI es una alternativa económica y muy versátil que se integra fácilmente con otras aplicaciones de Microsoft y bases de datos empresariales. Su interfaz de usuario también es bastante intuitiva, y permite crear visualizaciones de datos y reportes que optimizan los mecanismos internos, y facilitan la toma de decisiones estratégicas en tiempo real.

Aprende a dominar todas estas herramientas en 7 meses

Creamos un curso de análisis de datos desde cero, para que pases de manejar niveles básicos de Excel a ser un experto en Python y Spark. ¡Incluso podrás crear tus propios proyectos reales y tener sesiones con tu propio coach de carrera!

¿Cómo elegir la herramienta correcta?

Para decidir cuál es la herramienta de análisis de datos más adecuada para el proyecto hay que tener en cuenta el entorno, la medida del conjunto de datos, las necesidades específicas de cada usuario y los objetivos de la empresa.

Según el volumen y el tipo de datos

Este probablemente sea el punto más importante a la hora de decidir qué soluciones utilizar. Cuando se trata de grandes cantidades de datos o conjuntos de datos complejos siempre se recomienda Python o R. Y si vamos más allá, Python es mejor para proyectos que combinan análisis, visualización de datos, ML y desarrollo de aplicaciones, mientras que R es preferido cuando la prioridad es análisis estadístico, verificación científica y generación de gráficos detallados.

Cuando alguna empresa o institución necesita transformar grandes conjuntos de datos en periodos muy cortos, trabajan con bases de datos distribuidas y desarrollos de alto rendimiento, para lo cual son adecuados Apache Hadoop o Spark.

En cambio, las hojas de cálculo (Excel, Google Sheets) son ideales para conjuntos de datos pequeños o medianos; es decir, cuando se necesitan informes rápidos, limpieza de datos, almacenamiento en la nube o colaboración en tiempo real, antes de pasar a herramientas de análisis de datos más avanzadas.

Según el propósito del análisis

Identifica si lo que se busca es visualizar datos, crear informes, hacer minería de datos, y elige la herramienta que mejor soporte esas funciones.

Según la facilidad de uso y las habilidades de los usuarios

Es importante considerar la interfaz de usuario, la curva de aprendizaje de la herramienta y la disponibilidad de capacidades técnicas dentro del equipo.

Por ejemplo, Google Sheets o Excel son muy buenas para equipos junior o en desarrollo.

Según el costo y el tipo de plataforma

Puedes decidir entre elegir productos comerciales frente a herramientas de código abierto, siempre y cuando estos se alineen con el presupuesto de la empresa.

Según la facilidad en la integración

Siempre conviene verificar que una nueva herramienta sea compatible con las plataformas, software, bases de datos y almacenamiento que ya se utilizan en la organización.

Por ejemplo, si en la empresa utilizan el paquete de Microsoft, lo más conveniente es Power BI para crear las gráficas e informes.

Herramientas Open Source vs. Comerciales

Otra de los factores a tener en cuenta a la hora de elegir herramientas de análisis de datos es si se trata de un producto comercial o una solución de código abierto. Esto dependerá en gran parte del presupuesto, las necesidades y objetivos que tenga cada empresa u organización.

| Productos comerciales | Herramientas de código abierto |

| Ofrecen soporte técnico, actualizaciones periódicas y soluciones listas para integrarse con otras plataformas y software empresariales. Son ideales cuando la prioridad es la eficacia, la seguridad de los datos y la facilidad de uso, aunque implican un mayor costo. | Permiten flexibilidad, personalización y ahorro en presupuesto, lo que las hace útiles para organizaciones con equipos técnicos capaces de adaptar la herramienta a sus desarrollos. Son excelentes para proyectos que manejan grandes volúmenes de datos, y requieren análisis avanzado o integración con tecnologías como Apache Spark o Hadoop. |

Análisis de datos: casos de uso por industria

| Salud | Hospitales y laboratorios usan las herramientas de análisis de datos para monitorear pacientes, detectar patrones de enfermedades y optimizar la toma de decisiones clínicas basadas en datos en tiempo real. |

| Finanzas | Bancos y fintech aplican el análisis de datos para realizar las tareas de detección de fraudes, análisis de riesgos y creación de modelos predictivos que mejoran la gestión de información financiera. |

| Marketing y ventas | Empresas de consumo y agencias usan herramientas de análisis para segmentar clientes, identificar tendencias de compra y optimizar campañas basadas en datos de comportamiento. |

| Retail y e-commerce | Los comercios examinan datos de inventario, comportamiento de usuarios y ventas para predecir demanda, personalizar ofertas y mejorar la eficiencia operativa mediante análisis avanzados. |

Preguntas frecuentes sobre herramientas de análisis de datos

¿Cuáles son las mejores herramientas de análisis de datos?

¿Qué herramientas usar para grandes volúmenes de datos?

¿Para el análisis de datos es mejor usar herramientas de código abierto o comerciales?

¡Domina las herramientas de análisis de datos!

Dominar estas plataformas y softwares de análisis de datos es una de las habilidades más demandadas del mercado laboral. Con TripleTen puedes transformar tu carrera con el curso de analista de datos, especialmente diseñado para adaptarse a tu estilo de vida.

🔷 Duración: 7 meses.

🔷 Horario flexible: 20 horas de estudio por semana.

🔷 Únete desde cualquier lugar del mundo.

🔷 Asignaturas actualizadas a 2025.

🔷 Coaching personalizado por analistas con años de experiencia.

🔷 Formación intensiva en análisis de datos.

🔷 Desde $2,375 MXN al mes, con planes de pago a plazos disponibles.

¡Conviértete en un analista de datos certificado en 7 meses o te devolvemos tu dinero!

Reserva ahora tu lugar y domina las herramientas de análisis de datos más demandadas por las empresas en la actualidad.