Los 10 algoritmos de Machine Learning que debes conocer

Trabajar con algoritmos es esa habilidad con la que los científicos de datos se acercan a la magia. Los algoritmos constituyen la base de una amplia gama del trabajo de análisis de los datos que los científicos de datos realizan a diario. Por esta razón, son muy muy importantes las habilidades en la generación de algoritmos para conducirte a los segmentos más apasionantes de la ciencia de datos.

Veamos a continuación por qué se necesitan algoritmos y quién los utiliza, además de los tipos de algoritmos y sus propiedades, ejemplos del trabajo con algoritmos y los diez algoritmos de aprendizaje automático que como profesional de esta área sí o sí debes conocer.

¿Qué es un algoritmo de aprendizaje automático y cómo funciona?

Los algoritmos son esenciales para el trabajo que realiza la ciencia de datos, ya que son los motores de toma de decisiones formados por redes neuronales, aprendizaje profundo y procesamiento del lenguaje natural.

Un algoritmo en programación son las acciones que te permiten resolver un problema utilizando datos de entrenamiento. Además, estas deben ser secuenciales, es decir, realizarse en un orden determinado para poder obtener el resultado deseado.

Inicialmente, los algoritmos aparecen en las matemáticas; por ejemplo, en fórmulas para resolver una ecuación cuadrática. Pero, con el avance de la tecnología y la inteligencia artificial (IA), usar algoritmos ahora se extiende a diferentes áreas, como la programación informática, la fabricación de maquinaria o en la hospitalidad.

Principios básicos del aprendizaje automático

El aprendizaje automático (ML) es un proceso en el que un programa informático utiliza inteligencia artificial (IA) para aprender a resolver problemas con base en datos. Este lo lleva a cabo un especialista en ciencia de datos, quien se encarga de los elementos de procesamiento de datos para construir modelos de IA.

Para entrenar una máquina, el científico de datos primero debe recopilar una gran cantidad de datos sobre los cuales la computadora tomará decisiones. Un especialista en ciencia de datos debiera saber lo siguiente para entrenar máquinas:

• estructurar la información según las características;

• pensar lógicamente;

• conocer el lenguaje de programación Python, ya que en él están escritos los algoritmos para el procesamiento de datos;

• conocer Java y Scala, para las herramientas para el procesamiento de datos;

• dominar SQL, un lenguaje de consulta que se utiliza para obtener los datos disponibles de una base de datos;

• utilizar herramientas para trabajar con bases de datos (por ejemplo, el ecosistema Hadoop para crear lagos de datos).

No hay que olvidar que como primar paso, el especialista debe estudiar el objeto modelado y la influencia de factores externos. Esto para comprender cómo interactúan los tres parámetros y, como consecuencia, poder hacer un diagnóstico.

¿Cómo predicen los algoritmos?

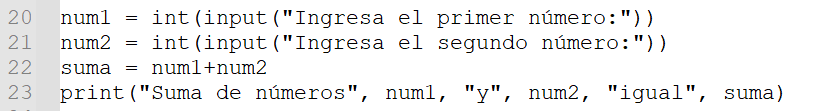

Tomemos por ejemplo una secuencia de acciones que calcula la suma de dos números. Para ello, la máquina:

1) Solicita al usuario dos números;

2) Suma estos números;

3) Muestra el resultado en la pantalla.

Es posible implementar este algoritmo en Python de la siguiente manera:

Se necesitan algoritmos para resolver problemas, obtener resultados predecibles e identificar errores en el trabajo si el resultado es inesperado. Afortunadamente, hoy el uso de algoritmos ha encontrado una aplicación práctica en casi todos los ámbitos de la actividad humana, donde el proceso debe seguir un determinado plan o escenario.

Utilizando algoritmos de redes neuronales, los científicos realizan investigaciones más profundas y los médicos hacen diagnósticos más precisos.

Principales algoritmos del Machine Learning que debes conocer

El aprendizaje automático se ha convertido en la piedra angular de la ciencia de datos moderna, ya que permite a profesionales extraer información significativa dentro de un conjunto de datos de clientes para tomar decisiones informadas en diversos sectores. Un conocimiento sólido de los principales algoritmos de ML es esencial para cualquier aspirante a científico de datos.

Estos son los diez tipos de algoritmos de aprendizaje automático que son altamente demandados en el campo actualmente:

1) Regresión lineal: la regresión lineal es un algoritmo de aprendizaje supervisado que se utiliza para modelar la relación entre una variable dependiente y una o más variables independientes. Predice resultados continuos, lo que lo hace útil para pronosticar ventas, estimar precios de viviendas o cualquier escenario en el que el objetivo sea predecir un valor numérico basado en características de entrada.

2) Regresión logística: a pesar de su nombre, la regresión logística se utiliza para tareas de clasificación y regresión. Estima la probabilidad de que una entrada determinada pertenezca a una categoría concreta, lo que la hace idea para aplicaciones que realizan actividades como la detección de spam, el diagnóstico de enfermedades y la predicción de la pérdida de clientes.

3) Árboles de decisión: los árboles de decisión son modelos intuitivos que dividen los datos en ramas para hacer predicciones basadas en los valores de un conjunto dado de características. Pueden realizar tanto tareas de regresión como de clasificación, y se valoran por su sencillez e interpretabilidad.

4) Máquinas de soporte vectorial (SVM): las SVM son potentes clasificadores que encuentran el límite óptimo entre las clases de un conjunto de datos. Son eficaces en espacios de alta dimensión y se utilizan en aplicaciones de clasificación de imágenes, donde es esencial distinguir entre diferentes objetos y la categorización de textos.

5) Vecinos más próximos (K-Nearest Neighbors): KNN es un algoritmo sencillo de aprendizaje basado en instancias que clasifica los puntos de datos en función de la clase mayoritaria entre sus «k» vecinos más cercanos. Se utiliza en los sistemas de recomendación que sugieren productos basados en preferencias similares de los usuarios, así como en el reconocimiento de patrones.

6) Redes neuronales artificiales: inspiradas en el cerebro humano, las redes neuronales artificiales consisten en capas interconectadas de nodos (neuronas) que pueden modelar patrones complejos en los datos. Son la base del Deep Learning, y se aplican en el reconocimiento de imágenes y del habla, en el procesamiento del lenguaje natural y en juegos como AlphaGo.

7) Bosques aleatorios: los bosques aleatorios son conjuntos de árboles de decisión que mejoran el rendimiento predictivo, lo que reduce el sobreajuste. Son versátiles y pueden usarse tanto para tareas de clasificación como de regresión. Entre sus aplicaciones se incluyen la selección de características —donde se identifican 'x' número de variables importantes— y la detección de enfermedades.

8) Agrupación K-Means: K-Means es un algoritmo de aprendizaje no supervisado que divide los datos en «k» agrupaciones distintas, en función de la similitud de sus características. Se utiliza comúnmente en la segmentación de clientes con comportamientos similares para el marketing dirigido, y la comprensión de imágenes a través de la reducción de colores en una imagen.

9) Análisis de componentes principales (PCA): el ACP es una técnica de reducción de dimensionalidad que transforma los datos de alta dimensión en una forma de menor dimensión, para preservar tanta variación como sea posible. Los algoritmos de reducción son útiles en el análisis exploratorio de datos, ya que ayudan a visualizar conjuntos complejos y a acelerar los algoritmos de aprendizaje profundo, a través de la reducción de dimensión (número de características de entrada).

10) Aprendizaje por refuerzo: el aprendizaje por refuerzo consiste en entrenar a los agentes para que tomen una secuencia de decisiones que recompensen los comportamientos deseados y castiguen los no deseados. Se utiliza en robótica para aprender tareas mediante ensayo y error, en el desarrollo de IA para juegos, y en la automatización de procesos industriales para optimizar las operaciones y aumentar la eficiencia.

Introducción a los algoritmos de regresión

Los algoritmos de regresión son fundamentales en el aprendizaje automático para modelar la relación entre una variable dependiente y una o más variables independientes. El análisis de regresión se utiliza principalmente para predecir resultados numéricos.

• Regresión lineal: este algoritmo asume una relación lineal entre las variables de entrada y salida, cuyos pasos se suceden claramente uno tras otro. Por ejemplo, predecir el precio de la vivienda basada en características como el tamaño, la ubicación y la edad.

• Regresión logística: aunque se utiliza para la clasificación, predice la probabilidad de un resultado binario. Por ejemplo, estimar la probabilidad de que un cliente compre un producto.

Algoritmos de aprendizaje supervisado

El aprendizaje supervisado consiste en entrenar un modelo a partir de datos etiquetados, de los que se conocen los pares de entrada y salida. El modelo aprende a hacer predicciones o tomar decisiones basadas en estos datos.

Un ejemplo de aplicación de aprendizaje supervisado es clasificar correos electrónicos como «spam» o «no spam» a través del aprendizaje de datos dentro de un rango de correos electrónicos.

Ejemplos de algoritmos de aprendizaje no supervisado

El aprendizaje no supervisado trabaja con datos no etiquetados, donde el objetivo del algoritmo es inferir la estructura natural presente en el conjunto de datos.

Dos ejemplos de algoritmos de aprendizaje no supervisado que ejecutan datos a través de relaciones no lineales son:

• K-Means Clustering: agrupa puntos de datos similares en agrupaciones, o clusters (por ejemplo, segmentar a los clientes en función de su comportamiento de compra).

• Análisis de componentes principales (PCA): reduce la dimensionalidad de los datos, y ayuda a visualizar y comprender cada punto de datos.

¿Cómo los algoritmos de aprendizaje automático clasifican los datos?

La clasificación en el aprendizaje automático consiste en asignar puntos de datos a categorías o etiquetas predefinidas para realizar una representación simplificada de los datos. El proceso comienza con el entrenamiento del modelo por medio de conjuntos de datos complejos (aprendizaje supervisado). El algoritmo aprende patrones y relaciones entre las características y las etiquetas, para hacer predicciones sobre datos no vistos y arrojar una clave de respuesta.

Los algoritmos de clasificación suelen dividir los datos en conjuntos de entrenamiento y conjuntos de pruebas. El proceso de entrenamiento consiste en minimizar los errores o maximizar la precisión mediante iteraciones, mientras que las pruebas evalúan que la generalización del modelo en respuesta a nuevos datos.

Algunos ejemplos son:

• la categorización de imágenes a través de la identificación de objetos en fotos;

• la clasificación de textos, como categorizar correos electrónicos como «spam» o «no spam»;

• el diagnóstico médico, como predecir si un paciente desarrollará cierta enfermedad, basándose en su historial, estudios y condición médicos.

Uso de árbol de decisión en la clasificación

Los árboles de decisión son uno de los algoritmos de clasificación más intuitivos. Para imitar la toma de decisiones humana, el algoritmo divide los datos para identificar en ramas, en función de predecir el valor de las características.

El algoritmo se basa en la regla: "Si <condición>, entonces <resultado esperado>". El algoritmo en este caso empieza por el nodo raíz, evalúa cada característica para decidir la mejor división, y continúa el proceso hasta que los datos están categorizados.

En análisis de datos y aprendizaje automático, no es necesario crear manualmente árboles de decisión; para ello, los analistas y científicos de datos utilizan bibliotecas especiales disponibles en dos lenguajes de programación: R y Python.

Algunos ejemplos prácticos del uso del árbol de decisión en la clasificación son:

• la aprobación de préstamos bancarios, para predecir si un solicitante debería recibir un préstamo de acuerdo con sus ingresos, puntuación crediticia y deuda;

• y la atención sanitaria, para el diagnóstico de enfermedades a través de los síntomas y el historial médico del paciente.

Aplicaciones de las redes neuronales en la clasificación

Las redes neuronales, en particular los modelos de aprendizaje profundo, destacan en tareas de clasificación complejas, gracias a su capacidad para modelar patrones intrincados. Estas están formadas por capas interconectadas de neuronas artificiales. Los datos de entrada se procesan a través de estas capas, de las cuales extrae características de cada una y aprende representaciones jerárquicas.

Algunos ejemplos de aplicaciones de las redes neuronales en los modelos de aprendizaje automático son:

• el reconocimiento del habla, con la clasificación de palabras o frases habladas;

• el reconocimiento de imágenes, con la identificación de objetos o rasgos faciales en imágenes;

• y el procesamiento del lenguaje natural (PLN), con la clasificación de sentimientos en textos como positivos, negativos o neutros.

Explorando los tipos de algoritmos más usados

Los diferentes algoritmos de aprendizaje automático se clasifican en función de cómo aprenden y del tipo de datos que procesan. Las principales categorías incluyen el aprendizaje supervisado, no supervisado y por refuerzo.

Diferencias entre aprendizaje profundo y aprendizaje supervisado

Mientras que el aprendizaje supervisado se basa en conjuntos de datos etiquetado y modelos más simples, el aprendizaje profundo (Deep Learning) utiliza redes neuronales profundas con múltiples capas para manejar tareas más complejas (como la generación de imágenes o la conducción autónoma). Sin embargo, no hay que olvidar que el aprendizaje profundo es un subconjunto del aprendizaje supervisado.

Los modelos de aprendizaje profundo requieren grandes conjuntos de datos y una potencia computacional significativa.

¿Qué es el aprendizaje por refuerzo?

El aprendizaje de refuerzo (RL) es un paradigma único en el que los modelos aprenden a tomar decisiones con base en su entorno, y por lo cual reciben recompensas o penalizaciones.

Un agente de RL representa una prueba: realiza acciones, recibe retroalimentación y ajusta su estrategia para maximizar las recompensas acumuladas. Algunos ejemplos de aprendizaje por refuerzo son el entrenamiento de la IA para jugar al ajedrez, o enseñar robots a manipular objetos.

Aplicaciones de algoritmos de aprendizaje por refuerzo

El aprendizaje por refuerzo encuentra un uso práctico en escenarios dinámicos de toma de decisiones con cada valor como independiente. Por ejemplo:

• en vehículos autónomos, al encontrar una manera de conducir de forma segura, sorteando las condiciones del tráfico;

• en la automatización industrial, al optimizar líneas de producción y mejorar el rendimiento de las máquinas mediante ensayo y error.

Casos de uso y tipos de algoritmos de Machine Learning

Los algoritmos de Machine Learning abordan diversos retos específicos para la industria tecnológica; desde la automatización, hasta las recomendaciones personalizadas. Es por ello que comprender los principales algoritmos de ML te equipará para superar los múltiples desafíos a los que un científico de datos se enfrenta día con día en un panorama tecnológico de tan rápida evolución.

Selección y aplicación de los grupos de algoritmos: ¿cómo elegir el adecuado para construir un modelo?

La elección del algoritmo adecuado dependerá de dos variables:

• Los tipos de datos — ya que los datos estructurados funcionan bien con árboles de decisión, mientras que los datos no estructurados (como las imágenes) se benefician de las redes neuronales.

• El objetivo — pues así como la predicción de valores numéricos favorece los modelos de regresión, la categorización de elementos conviene a los algoritmos de clasificación.

Factores a considerar en la selección de algoritmos

• Tamaño de los datos: algoritmos como KNN tienen dificultades con conjuntos de datos grandes.

• Precisión deseada: los modelos complejos ofrecen mayor precisión, pero requieren más cálculos.

• Tiempo de procesamiento: los algoritmos más sencillos, como la regresión logística, son más rápidos con conjuntos de datos pequeños.

Impacto de los conjuntos de datos en la selección de algoritmos

Asimismo, la calidad y la cantidad de los datos influyen significativamente en el rendimiento de la siguiente manera:

• Calidad: los datos limpios y relevantes reducen el ruido y mejoran la precisión;

• Cantidad: los grandes conjuntos de datos son esenciales para entrenar modelos robustos, especialmente en el Deep Learning;

• Variedad: los conjuntos de datos diversos garantizan que el modelo generalice bien en nuevos escenarios.

El estudio de los algoritmos debe comenzar con diagramas de flujo que se pueden encontrar en la vida cotidiana—por ejemplo, al establecer recetas y procesos paso a paso. Esto te permitirá comprender rápidamente los algoritmos y abordar el dominio de los lenguajes de programación con una base mínima.

Como científico de datos, es posible que apliques un tipo de algoritmo con más frecuencia que otro. Lo que es un hecho es que estos especialistas han revolucionado el futuro del trabajo y la tecnología con la aplicación de algoritmos, desde las tareas de clasificación en redes neuronales, hasta la toma de decisiones con el aprendizaje por refuerzo.

Si te interesa la programación informática, antes de comenzar a aprender los lenguajes de programación, sería útil estudiar algoritmos. Y una buena educación en ciencia de datos te proporcionará una base de conocimientos que te permita empezar a trabajar con algoritmos. Puedes obtenerla en un bootcamp de Data Science como el de TripleTen. Conoce más sobre nuestro programa de ciencia de datos aquí.